и§ЈеҶіAIвҖңй«ҳеҲҶдҪҺиғҪвҖқйңҖиҰҒеҚҮзә§зҡ„жҳҜиҖғж ёжңәеҲ¶

еҸӮдёҺдә’еҠЁ

еҸӮдёҺдә’еҠЁгҖҖгҖҖи§ЈеҶіAIвҖңй«ҳеҲҶдҪҺиғҪвҖқйңҖиҰҒеҚҮзә§зҡ„жҳҜиҖғж ёжңәеҲ¶

гҖҖгҖҖзӣ®еүҚйғЁеҲҶдәәе·ҘжҷәиғҪжІүиҝ·еҲ·жҰңпјҢеңЁеҹәеҮҶжөӢиҜ•ж—¶й«ҳеҲҶйҖҡиҝҮпјҢиЎЁзҺ°дјҳејӮпјҢдҪҶе®һйҷ…еә”з”ЁдёӯеҚҙиҝҳдјҡзҠҜдёҖдәӣйқһеёёеҹәзЎҖзҡ„й”ҷиҜҜгҖӮ

гҖҖгҖҖв—Һжң¬жҠҘи®°иҖ… еҚҺ еҮҢ

гҖҖгҖҖиҝ‘ж—ҘпјҢжңүеӘ’дҪ“жҠҘйҒ“пјҢзӣ®еүҚйғЁеҲҶдәәе·ҘжҷәиғҪжІүиҝ·еҲ·жҰңпјҢеңЁеҹәеҮҶжөӢиҜ•ж—¶й«ҳеҲҶйҖҡиҝҮпјҢиЎЁзҺ°дјҳејӮпјҢдҪҶе®һйҷ…еә”з”ЁдёӯеҚҙиҝҳдјҡзҠҜдёҖдәӣйқһеёёеҹәзЎҖзҡ„й”ҷиҜҜгҖӮиҝҷз§ҚжІүиҝ·еҲ·жҰңпјҢеҝҪз•Ҙе®һз”ЁжҖ§иҙЁзҡ„иЎҢдёәйҖ жҲҗдәҶйғЁеҲҶAIжЁЎеһӢвҖңй«ҳеҲҶдҪҺиғҪвҖқзҡ„зҺ°иұЎгҖӮйӮЈд№ҲпјҢеҜ№дәҺAIеҸ‘еұ•иҖҢиЁҖпјҢеҹәеҮҶжөӢиҜ•жҳҜеҗҰеҝ…иҰҒпјҹеңЁе®һйҷ…еә”з”ЁдёӯпјҢеҹәеҮҶжөӢиҜ•е“Әдәӣй—®йўҳжңүеҫ…ж”№иҝӣе®Ңе–„е‘ўпјҹ

гҖҖгҖҖAIжЁЎеһӢе“Ә家еҘҪпјҢеҹәеҮҶжөӢиҜ•жқҘиҜҙиҜқ

гҖҖгҖҖAIжЁЎеһӢеә”иҜҘеҰӮдҪ•иЎЎйҮҸе…¶жҖ§иғҪпјҹ

гҖҖгҖҖвҖңзӣ®еүҚAIжЁЎеһӢиғҪеҠӣзҡ„й«ҳдҪҺеҸ–еҶідәҺж•°жҚ®пјҢеӣ дёәAIзҡ„жң¬иҙЁжҳҜеӯҰд№ ж•°жҚ®пјҢиҫ“еҮәз®—жі•жЁЎеһӢгҖӮдёәдәҶе…¬е№іиЎЎйҮҸAIиғҪеҠӣпјҢеҫҲеӨҡжңәжһ„гҖҒдјҒдёҡз”ҡиҮіз§‘еӯҰ家дјҡ收йӣҶгҖҒи®ҫи®ЎдёҚеҗҢзҡ„ж•°жҚ®йӣҶпјҢе…¶дёӯдёҖйғЁеҲҶе–Ӯз»ҷAIи®ӯз»ғпјҢеҫ—еҲ°AIжЁЎеһӢпјҢеҸҰеӨ–дёҖйғЁеҲҶж•°жҚ®з”ЁдәҺиҖғж ёAIжЁЎеһӢзҡ„иғҪеҠӣпјҢиҝҷе°ұжҳҜеҹәеҮҶжөӢиҜ•гҖӮвҖқиҝ‘ж—ҘпјҢиҘҝе®үз”өеӯҗ科жҠҖеӨ§еӯҰз”өеӯҗе·ҘзЁӢеӯҰйҷўж•ҷжҺҲеҗҙ家йӘҘжҺҘеҸ—科жҠҖж—ҘжҠҘи®°иҖ…йҮҮи®ҝж—¶иЎЁзӨәгҖӮ

гҖҖгҖҖеҗҙ家йӘҘд»Ӣз»ҚиҜҙпјҢжңәеҷЁеӯҰд№ и¶ҠжқҘи¶ҠеӨҡең°з”ЁдәҺеҗ„з§Қе®һйҷ…еә”з”ЁеңәжҷҜпјҢдҫӢеҰӮеӣҫеғҸе’ҢиҜӯйҹіиҜҶеҲ«гҖҒиҮӘеҠЁй©ҫ驶жұҪиҪҰгҖҒеҢ»еӯҰиҜҠж–ӯзӯүгҖӮеӣ жӯӨпјҢдәҶи§Је…¶еңЁе®һи·өдёӯзҡ„иЎҢдёәе’ҢжҖ§иғҪеҸҳеҫ—йқһеёёйҮҚиҰҒгҖӮе…¶йІҒжЈ’жҖ§е’ҢдёҚзЎ®е®ҡжҖ§зҡ„й«ҳиҙЁйҮҸдј°и®ЎеҜ№дәҺи®ёеӨҡеҠҹиғҪиҮіе…ійҮҚиҰҒпјҢе°Өе…¶жҳҜеңЁж·ұеәҰеӯҰд№ йўҶеҹҹгҖӮдёәжҺҢжҸЎжЁЎеһӢзҡ„иЎҢдёәпјҢз ”з©¶дәәе‘ҳиҰҒж №жҚ®зӣ®ж Үд»»еҠЎзҡ„еҹәзәҝжқҘиЎЎйҮҸе…¶жҖ§иғҪгҖӮ

гҖҖгҖҖ2010е№ҙпјҢеҹәдәҺImageNetж•°жҚ®йӣҶзҡ„и®Ўз®—жңәи§Ҷи§үз«һиөӣзҡ„жҺЁеҮәпјҢжҝҖеҸ‘дәҶж·ұеәҰеӯҰд№ йўҶеҹҹдёҖеңәз®—жі•дёҺж•°жҚ®зҡ„йқ©е‘ҪгҖӮд»ҺжӯӨпјҢеҹәеҮҶжөӢиҜ•жҲҗдёәиЎЎйҮҸAIжЁЎеһӢжҖ§иғҪзҡ„дёҖдёӘйҮҚиҰҒжүӢж®өгҖӮеҫ®иҪҜе…¬еҸёзҡ„и®Ўз®—жңә科еӯҰ家马еЎһжҙӣВ·йҮҢиҙқзҪ—иЎЁзӨәпјҢеҹәеҮҶжөӢиҜ•еә”иҜҘжҳҜд»ҺдёҡиҖ…е·Ҙе…·з®ұдёӯзҡ„дёҖдёӘе·Ҙе…·пјҢдәә们用еҹәеҮҶжқҘд»ЈжӣҝеҜ№дәҺжЁЎеһӢзҡ„зҗҶи§ЈпјҢйҖҡиҝҮеҹәеҮҶж•°жҚ®йӣҶжқҘжөӢиҜ•вҖңжЁЎеһӢзҡ„иЎҢдёәвҖқгҖӮ

гҖҖгҖҖдҫӢеҰӮпјҢеңЁиҮӘ然иҜӯиЁҖеӨ„зҗҶйўҶеҹҹпјҢGLUEз§‘з ”дәәе‘ҳи®©AIжЁЎеһӢеңЁеҢ…еҗ«дёҠеҚғдёӘеҸҘеӯҗзҡ„ж•°жҚ®йӣҶдёҠи®ӯз»ғпјҢ并еңЁ9дёӘд»»еҠЎдёҠиҝӣиЎҢжөӢиҜ•пјҢжқҘеҲӨж–ӯдёҖдёӘеҸҘеӯҗжҳҜеҗҰз¬ҰеҗҲиҜӯжі•пјҢ并еҲҶжһҗжғ…ж„ҹпјҢжҲ–иҖ…еҲӨж–ӯдёӨдёӘеҸҘеӯҗд№Ӣй—ҙжҳҜеҗҰжҳҜйҖ»иҫ‘и•ҙж¶өзӯүпјҢдёҖеәҰйҡҫеҖ’дәҶAIжЁЎеһӢгҖӮйҡҸеҗҺпјҢз§‘з ”дәәе‘ҳжҸҗй«ҳдәҶеҹәеҮҶжөӢиҜ•йҡҫеәҰпјҢдёҖдәӣд»»еҠЎиҰҒжұӮAIжЁЎеһӢдёҚд»…иғҪеӨҹеӨ„зҗҶеҸҘеӯҗпјҢиҝҳиҰҒеӨ„зҗҶжқҘиҮӘз»ҙеҹәзҷҫ科жҲ–ж–°й—»зҪ‘з«ҷзҡ„ж®өиҗҪеҗҺеӣһзӯ”йҳ…иҜ»зҗҶи§Јй—®йўҳгҖӮд»…з»ҸиҝҮ1е№ҙзҡ„еҸ‘еұ•пјҢAIжЁЎеһӢзҡ„жҖ§иғҪд»ҺдёҚеҲ°70еҲҶиҪ»жқҫиҫҫеҲ°90еҲҶпјҢи¶…и¶ҠдәҶдәәзұ»гҖӮ

гҖҖгҖҖеҗҙ家йӘҘиЎЁзӨәпјҡвҖң科еӯҰз ”з©¶иҰҒжңү科еӯҰй—®йўҳгҖҒж–№жі•гҖҒи®Ўз®—гҖҒиҜ•йӘҢеҜ№жҜ”зӯүиҰҒзҙ гҖӮеӣ жӯӨеңЁиҝӣиЎҢ科еӯҰз ”з©¶пјҢеҢ…жӢ¬дәәе·ҘжҷәиғҪзҡ„з§‘з ”дёӯпјҢд№ҹеҝ…йЎ»жңүи®Ўз®—дёҺиҜ•йӘҢеҜ№жҜ”пјҢд№ҹе°ұжҳҜиҜҙAIз®—жі•зҡ„иғҪеҠӣеә”иҜҘжҳҜеҸҜжөӢйҮҸзҡ„пјҢзӣ®зҡ„жҳҜйӘҢиҜҒз ”з©¶ж–№жі•зҡ„еҸҜиЎҢжҖ§гҖҒжңүж•ҲжҖ§гҖӮеӣ жӯӨпјҢеҹәеҮҶжөӢиҜ•еҫҲжңүеҝ…иҰҒпјҢиҝҷж ·жүҚеҸҜд»Ҙе…¬е№ійӘҢиҜҒAIз®—жі•иғҪеҠӣзҡ„й«ҳдҪҺеҘҪеқҸпјҢйҒҝе…Қеҗ„иҜҙеҗ„иҜқпјҢвҖҳзҺӢе©ҶеҚ–з“ңиҮӘеҚ–иҮӘеӨёвҖҷгҖӮвҖқ

гҖҖгҖҖз®—жі•жңҖз»ҲжңҚеҠЎе®һи·өпјҢиҖҢйқһеҲ·жҰң

гҖҖгҖҖжңүдәәиҜҙпјҢй«ҳеҲҶжҳҜAIжЁЎеһӢзҡ„е…ҙеҘӢеүӮгҖӮдәҺжҳҜпјҢжңүзҡ„дәәе·ҘжҷәиғҪдёәдәҶеҸ–еҫ—еҘҪжҲҗз»©иҖҢйў‘йў‘еҲ·жҰңгҖӮ

гҖҖгҖҖеҫ®иҪҜе…¬еҸё2020е№ҙеҸ‘еёғжҠҘе‘ҠжҢҮеҮәпјҢеҢ…жӢ¬еҫ®иҪҜгҖҒи°·жӯҢе’Ңдәҡ马йҖҠеңЁеҶ…зҡ„еҗ„з§ҚsotaжЁЎеһӢеҢ…еҗ«иҜёеӨҡйҡҗеҗ«й”ҷиҜҜпјҢжҜ”еҰӮжҠҠеҸҘеӯҗйҮҢзҡ„вҖңwhat'sвҖқж”№жҲҗвҖңwhat isвҖқпјҢжЁЎеһӢзҡ„иҫ“еҮәз»“жһңе°ұдјҡжҲӘ然дёҚеҗҢпјҢиҖҢеңЁжӯӨеүҚпјҢд»ҺжІЎжңүдәәж„ҸиҜҶеҲ°иҝҷдәӣжӣҫиў«иҜ„д»·иҝҳдёҚй”ҷзҡ„е•ҶдёҡжЁЎеһӢз«ҹдјҡеңЁеә”з”ЁдёӯеҰӮжӯӨзіҹзі•гҖӮжҳҫ然пјҢиҝҷж ·и®ӯз»ғеҮәзҡ„AIжЁЎеһӢе°ұеғҸдёҖдёӘеҸӘдјҡиҖғиҜ•гҖҒжҲҗз»©дјҳејӮзҡ„еӯҰз”ҹпјҢеҸҜд»ҘжҲҗеҠҹйҖҡиҝҮ科еӯҰ家и®ҫзҪ®зҡ„еҗ„з§ҚеҹәеҮҶжөӢиҜ•пјҢеҚҙдёҚжҮӮдёәд»Җд№ҲгҖӮ

гҖҖгҖҖвҖңдёәдәҶиҺ·еҫ—еҘҪжҲҗз»©пјҢз ”з©¶дәәе‘ҳеҸҜиғҪдјҡдҪҝз”Ёзү№ж®Ҡзҡ„иҪҜ硬件и®ҫзҪ®еҜ№жЁЎеһӢиҝӣиЎҢи°ғж•ҙе’ҢеӨ„зҗҶпјҢи®©AIеңЁжөӢиҜ•дёӯиЎЁзҺ°еҮәиүІпјҢдҪҶиҝҷдәӣжҖ§иғҪеңЁзҺ°е®һдё–з•ҢдёӯеҚҙж— жі•ж–Ҫеұ•гҖӮвҖқиҘҝе®үз”өеӯҗ科жҠҖеӨ§еӯҰз ”з©¶е‘ҳе°ҡеқӨжҢҮеҮәгҖӮ

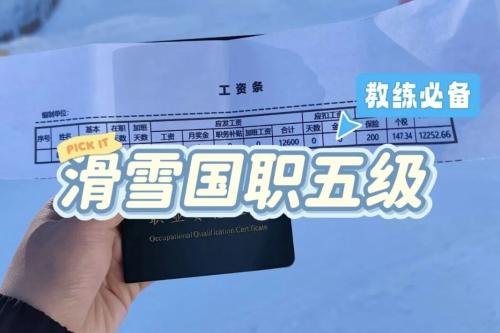

гҖҖгҖҖеңЁжҷәиғҪжүӢжңәйўҶеҹҹпјҢжҲ‘们и°ҲеҸҠжүӢжңәзҡ„дҪҝз”ЁдҪ“йӘҢж—¶дёҖиҲ¬йғҪдёҚе…Қдјҡж¶үеҸҠжүӢжңәзҡ„жҖ§иғҪиЎЁзҺ°пјҢиҝҷдәӣжҖ§иғҪйҖҡеёёдјҡз”Ёи·‘еҲҶжҲҗз»©жқҘиЎЁзҺ°гҖӮ然иҖҢпјҢжҲ‘们常常дјҡйҒҮеҲ°дёҖж¬ҫжүӢжңәзҡ„и·‘еҲҶжҲҗз»©еӨ„дәҺжҺ’иЎҢжҰңйўҶе…Ҳж°ҙе№іпјҢдҪҶжҳҜеңЁе®һйҷ…дҪҝз”ЁиҝҮзЁӢдёӯеҚҙеҮәзҺ°еҠЁз”»жҺүеё§гҖҒйЎөйқўж»‘еҠЁеҚЎйЎҝгҖҒеә”з”ЁеҒҮжӯ»зӯүзҡ„зҺ°иұЎгҖӮе…ЁзҗғйЎ¶зә§иҜ„жөӢзҪ‘з«ҷAnandTechзҡ„дёҖзҜҮжҠҘйҒ“жӣҫеҜ№иҝҷз§ҚзҺ°иұЎжҸҗеҮәиҙЁз–‘пјҢжҢҮеҮәжҹҗе“ҒзүҢжүӢжңәи·‘еҲҶж—¶еҗҜеҠЁдәҶвҖңжҖ§иғҪжЁЎејҸвҖқпјҢиҖҢеңЁе№іж—¶зҡ„дҪҝз”ЁдёӯвҖңжҖ§иғҪжЁЎејҸвҖқеҫҲе°‘иў«и°ғз”ЁејҖеҗҜгҖӮиҝҷз§ҚеӨ„зҗҶж–№ејҸиҷҪ然иғҪеӨҹиҺ·еҫ—й«ҳи·‘еҲҶпјҢдҪҶжҳҜдёҚиғҪжЁЎжӢҹз”ЁжҲ·зңҹе®һзҡ„дҪҝз”Ёжғ…жҷҜпјҢиҝҷи®©еҹәеҮҶжөӢиҜ•дёҚе…·жңүеҸӮиҖғж„Ҹд№үгҖӮ

гҖҖгҖҖе°ҡеқӨи®ӨдёәпјҢй’ҲеҜ№дёҠиҝ°й—®йўҳпјҢж”№иҝӣеҹәеҮҶзҡ„ж–№жі•дё»иҰҒжңүпјҡдёҖз§ҚжҳҜеўһеҠ жӣҙеӨҡзҡ„ж•°жҚ®йӣҶпјҢи®©еҹәеҮҶеҸҳеҫ—жӣҙйҡҫгҖӮз”ЁжІЎжңүи§ҒиҝҮзҡ„ж•°жҚ®жөӢиҜ•пјҢиҝҷж ·жүҚиғҪеҲӨж–ӯAIжЁЎеһӢжҳҜеҗҰиғҪеӨҹйҒҝе…ҚиҝҮжӢҹеҗҲгҖӮз ”з©¶дәәе‘ҳеҸҜеҲӣе»әдёҖдёӘеҠЁжҖҒж•°жҚ®ж”¶йӣҶе’ҢеҹәеҮҶжөӢиҜ•е№іеҸ°пјҢй’ҲеҜ№жҜҸдёӘд»»еҠЎпјҢйҖҡиҝҮдј—еҢ…зҡ„ж–№ејҸпјҢжҸҗдәӨ他们и®Өдёәдәәе·ҘжҷәиғҪжЁЎеһӢдјҡй”ҷиҜҜеҲҶзұ»зҡ„ж•°жҚ®пјҢжҲҗеҠҹж¬әйӘ—еҲ°жЁЎеһӢзҡ„ж ·дҫӢиў«еҠ е…ҘеҹәеҮҶжөӢиҜ•дёӯгҖӮеҰӮжһңеҠЁжҖҒең°ж”¶йӣҶж•°жҚ®еўһеҠ ж ҮжіЁпјҢеҗҢж—¶иҝӯд»ЈејҸзҡ„и®ӯз»ғжЁЎеһӢпјҢиҖҢдёҚжҳҜдҪҝз”Ёдј з»ҹзҡ„йқҷжҖҒж–№ејҸпјҢAIжЁЎеһӢеә”иҜҘеҸҜд»Ҙе®һзҺ°жӣҙе®һиҙЁжҖ§зҡ„иҝӣеҢ–гҖӮ

гҖҖгҖҖе°ҡеқӨиҜҙпјҢеҸҰдёҖз§ҚжҳҜзј©е°Ҹе®һйӘҢе®ӨеҶ…ж•°жҚ®е’ҢзҺ°е®һеңәжҷҜд№Ӣй—ҙзҡ„е·®и·қгҖӮеҹәзәҝжөӢиҜ•ж— и®әеҲҶж•°еӨҡй«ҳпјҢиҝҳжҳҜиҰҒз”Ёе®һйҷ…еңәжҷҜдёӢзҡ„ж•°жҚ®жқҘжЈҖйӘҢпјҢжүҖд»ҘйҖҡиҝҮеҜ№ж•°жҚ®йӣҶиҝӣиЎҢжӣҙиҙҙиҝ‘зңҹе®һеңәжҷҜзҡ„еўһејәе’Ңжү©е®№дҪҝеҫ—еҹәеҮҶжөӢиҜ•жӣҙеҠ жҺҘиҝ‘зңҹе®һеңәжҷҜгҖӮеҰӮImageNet-Cж•°жҚ®йӣҶпјҢеҸҜж №жҚ®16з§ҚдёҚеҗҢзҡ„е®һйҷ…з ҙеқҸзЁӢеәҰеҜ№еҺҹжңүзҡ„ж•°жҚ®йӣҶиҝӣиЎҢжү©е……пјҢеҸҜд»ҘжӣҙеҘҪжЁЎжӢҹе®һйҷ…ж•°жҚ®еӨ„зҗҶеңәжҷҜгҖӮ

гҖҖгҖҖеә”з”Ёе№ҝжіӣпјҢйңҖе°Ҫеҝ«е»әз«ӢеӣҪ家ж ҮеҮҶ

гҖҖгҖҖзҫҺеӣҪйә»зңҒзҗҶе·ҘеӯҰйҷўCleanlabе®һйӘҢе®Өзҡ„з ”з©¶жҢҮеҮәпјҢеёёз”Ёзҡ„10дёӘдҪңдёәеҹәеҮҶзҡ„ж•°жҚ®йӣҶдёӯпјҢжңүи¶…иҝҮ3%зҡ„ж ҮжіЁжҳҜй”ҷиҜҜзҡ„пјҢеҹәдәҺиҝҷдәӣеҹәеҮҶи·‘еҲҶзҡ„з»“жһңеҲҷж— еҸӮиҖғж„Ҹд№үгҖӮ

гҖҖгҖҖвҖңеҰӮжһңиҜҙпјҢеҹәеҮҶжөӢиҜ•е Әз§°дәәе·ҘжҷәиғҪйўҶеҹҹзҡ„вҖҳ科дёҫеҲ¶вҖҷпјҢйӮЈд№ҲпјҢвҖҳе”ҜеҲҶж•°и®әвҖҷиҫ“иөўпјҢжҳҜдёҚеҸҜиғҪи®ӯз»ғеҮәзңҹжӯЈзҡ„еҘҪжЁЎеһӢгҖӮиҰҒжү“з ҙжӯӨз§ҚзҺ°иұЎпјҢдёҖж–№йқўйңҖиҰҒйҮҮз”Ёжӣҙе…Ёйқўзҡ„иҜ„дј°ж–№жі•пјҢеҸҰдёҖж–№йқўеҸҜд»ҘиҖғиҷ‘жҠҠй—®йўҳеҲҶиҖҢжІ»д№ӢпјҢжҜ”еҰӮз”ЁеӨҡдёӘAIжЁЎеһӢи§ЈеҶіеӨҚжқӮй—®йўҳпјҢжҠҠеӨҚжқӮй—®йўҳиҪ¬еҢ–дёәз®ҖеҚ•зЎ®е®ҡзҡ„й—®йўҳгҖӮз®ҖеҚ•дё”з»ҸиҝҮдјҳеҢ–зҡ„еҹәзәҝжЁЎеһӢеҫҖеҫҖдјҳдәҺжӣҙеӨҚжқӮзҡ„ж–№жі•гҖӮи°·жӯҢзҡ„з ”з©¶дәәе‘ҳдёәеёёи§Ғзҡ„AIд»»еҠЎеј•е…ҘдәҶдёҚзЎ®е®ҡжҖ§еҹәзәҝеә“пјҢжқҘжӣҙеҘҪиҜ„дј°AIеә”з”Ёзҡ„зЁіеҒҘжҖ§е’ҢеӨ„зҗҶеӨҚжқӮдёҚзЎ®е®ҡжҖ§зҡ„иғҪеҠӣгҖӮвҖқиҝңжңӣжҷәеә“дәәе·ҘжҷәиғҪдәӢдёҡйғЁйғЁй•ҝгҖҒеӣҫзҒөжңәеҷЁдәәйҰ–еёӯжҲҳз•Ҙе®ҳи°ӯиҢ—жҙІжҢҮеҮәгҖӮ

гҖҖгҖҖиҷҪ然иЎҢдёҡжӯЈеңЁж”№еҸҳеҜ№дәҺеҹәеҮҶзҡ„жҖҒеәҰпјҢдҪҶзӣ®еүҚеҹәеҮҶжөӢиҜ•з ”究д»Қ然жҳҜдёҖдёӘе°Ҹдј—з ”з©¶гҖӮи°·жӯҢеңЁдёҖд»Ҫз ”з©¶дёӯйҮҮи®ҝдәҶе·Ҙдёҡз•Ңе’ҢеӯҰжңҜз•Ңзҡ„53дҪҚAIд»ҺдёҡиҖ…пјҢе…¶дёӯи®ёеӨҡдәәжҢҮеҮәпјҢж”№иҝӣж•°жҚ®йӣҶдёҚеҰӮи®ҫи®ЎжЁЎеһӢжӣҙжңүжҲҗе°ұж„ҹгҖӮ

гҖҖгҖҖи°ӯиҢ—жҙІиЎЁзӨәпјҢAIеә”з”ЁеҹәеҮҶз ”з©¶жҳҜжһ„е»әеӣҪеҶ…з»ҹдёҖеӨ§еёӮеңәзҡ„еҶ…еңЁйңҖиҰҒпјҢеҪ“еүҚAIе·Із»ҸеңЁеӣҪи®Ўж°‘з”ҹзҡ„еҗ„зұ»йўҶеҹҹдёӯеҫ—еҲ°е№ҝжіӣеә”з”ЁпјҢжӣҙйңҖиҰҒи®ҫз«Ӣж ҮеҮҶеҜ№AIжЁЎеһӢиҝӣиЎҢе…Ёйқўжңүж•Ҳзҡ„иҜ„дј°пјҢзүҮйқўиҝҪжұӮе’ҢйҮҮз”Ёй«ҳеҲҶAIжЁЎеһӢпјҢеҸҜиғҪдјҡи®©жЁЎеһӢеңЁеӨҚжқӮжһҒз«ҜеңәжҷҜдёӢеҮәзҺ°вҖңжҷәйҡңвҖқиЎҢдёәпјҢ并且еҸҜиғҪз”ұдәҺи®ӯз»ғе’ҢжҺЁзҗҶжҖ§иғҪзҡ„дҪҺж•ҲпјҢйҖ жҲҗдёҚиүҜзӨҫдјҡеҪұе“ҚгҖҒз»ҸжөҺжҚҹеӨұе’ҢзҺҜеўғз ҙеқҸгҖӮ

гҖҖгҖҖи°ӯиҢ—жҙІејәи°ғпјҢAIеә”з”ЁеҹәеҮҶз ”з©¶е…ід№ҺеӣҪ家жҲҳз•ҘгҖӮй’ҲеҜ№йҮҚиҰҒйўҶеҹҹпјҢе»әз«ӢжҲ‘еӣҪиҮӘе·ұзҡ„AIеҹәеҮҶжөӢиҜ•ж ҮеҮҶгҖҒAIж•°жҚ®йӣҶгҖҒAIжЁЎеһӢиҜ„дј°ж ҮеҮҶзӯүиҝ«еңЁзңүзқ«гҖӮ

гҖҖгҖҖжҚ®дәҶи§ЈпјҢиҘҝе®үз”өеӯҗ科жҠҖеӨ§еӯҰзҡ„DvcLabд№ҹеңЁAIеҹәеҮҶжөӢиҜ•иҝҷдёӘйўҶеҹҹиҝӣиЎҢдәҶеүҚзһ»жҖ§з ”究пјҢзү№еҲ«жҳҜй’ҲеҜ№AIеә”з”ЁеҹәеҮҶжөӢиҜ•дёӯж•°жҚ®йӣҶзҡ„ж•ҙдҪ“иҙЁйҮҸдёҺеҠЁжҖҒжү©еұ•дёӨдёӘе…ій”®й—®йўҳпјҢжӯЈеңЁејҖеҸ‘еҸҜеңЁзәҝеҚҸдҪңзҡ„ж•°жҚ®ж ҮжіЁдёҺAIжЁЎеһӢз ”еҸ‘жүҳз®ЎйЎ№зӣ®пјҢ并计еҲ’д»Ҡе№ҙйҷҶз»ӯејҖжәҗпјҢжӯЈеңЁдёәжһ„е»әеӣҪ家AIеҹәеҮҶиҜ„дј°ж ҮеҮҶдҪ“зі»иҝӣиЎҢз§ҜжһҒжҺўзҙўгҖӮ

зӨҫдјҡж–°й—»зІҫйҖүпјҡ

- 2026е№ҙ01жңҲ24ж—Ҙ 11:50:24

- 2026е№ҙ01жңҲ24ж—Ҙ 10:52:30

- 2026е№ҙ01жңҲ23ж—Ҙ 16:36:33

- 2026е№ҙ01жңҲ23ж—Ҙ 16:33:46

- 2026е№ҙ01жңҲ23ж—Ҙ 16:22:02

- 2026е№ҙ01жңҲ23ж—Ҙ 16:14:27

- 2026е№ҙ01жңҲ23ж—Ҙ 15:54:40

- 2026е№ҙ01жңҲ23ж—Ҙ 11:06:52

- 2026е№ҙ01жңҲ23ж—Ҙ 10:33:09

- 2026е№ҙ01жңҲ22ж—Ҙ 20:52:19